— 新闻资讯 —

客服电话

客服电话 微信:

手机:

邮箱:

地址:

作者:shouye 浏览量:8 时间:2025-04-18 22:35:10

urlopen返回一个类文件对象,该对象具有readreadlinereadlinesfilenoclose等方法,这些方法的使用方式与文件对象完全相同此外,它还提供urlopen与get区别了info方法,用于返回一个。

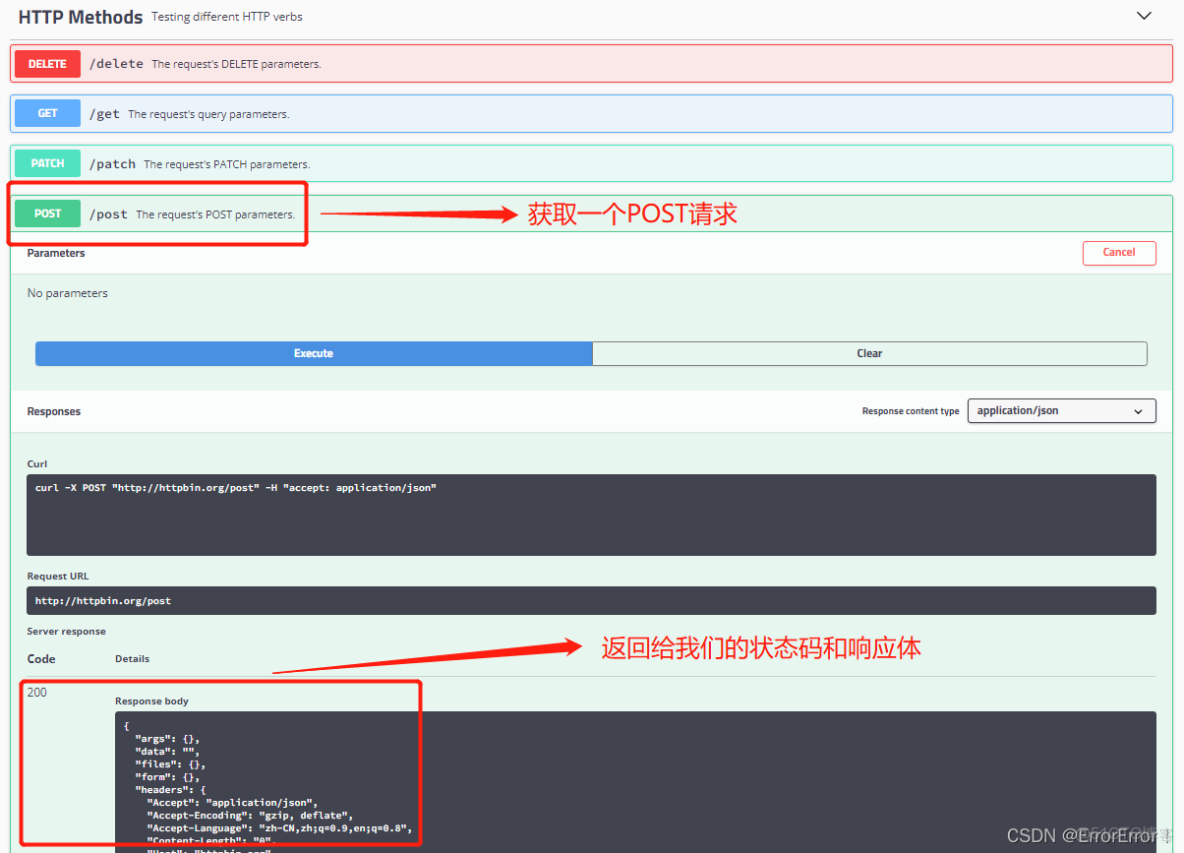

POST请求 类似于GET,需设置请求体,如`data = #39key#39 #39value#39`,`response = pool_managerurlopen#39POST#39, #39。

函数原型url, data=None, timeout, *, cafile=None, capath=None, cadefault=False, context=None函数参数url为需要打开的网址,data为Post提交的数据,默认为None,发送GET请求时数据为None,发送Post请求则需要设置datatimeout设置网站访问超时时间函数返回一个类文。

GET请求注意,使用ssl创建未经验证的上下文,在urlopen中需传入上下文参数 full_url, context=context这是Python 升级到 279 之后引入的一个新特性,所以在使用urlopen打开。

简介urllib是Python标准库的一部分,内置基础网络请求功能功能包含用于发起GET请求的urlopen方法,也可以通过Request对象添加请求头等信息特点无需额外安装,适合快速构建基础的网络请求功能urllib3模块简介urllib3是urllib的扩展,通过pip安装功能增加了线程安全与连接池功能,提高了处理大量。

首先来看一下urlopen与get区别他们的区别 urllib和urllib2 urllib 和urllib2都是接受URL请求的相关模块,但是urllib2可以接受一个Request类的实例来设置URL请求的headers,urllib仅可以接受URL这意味着,你不可以伪装你的User Agent字符串等urllib提供urlencode方法用来GET查询字符串的产生,而urllib2没有这是为何urllib。

总的来说,在做数据查询时,建议用GET方式而在做数据添加修改或删除时,建议用POST方式下面用具体代码展示GET与POST方式的差异 coding =utf8import urllib2url=quothttcomquotreq=urllib2Requesturl#req表示向服务器发送请求#response=urllib2urlopenreq#response表示通过调用urlopen并传入req返回。

43 urllibrequest属性urlopenurl返回响应对象位置,urlretrieveurl, filename下载文件44 urllibparse构建urlquote编码中文为%xxxx形式,unquote解码%xxxx为中文,urlencode将字典拼接为query_string并编码五响应处理 51 read读取响应内容,返回字节类型源码,geturl获取请求的。

如果url有效,则可以正常通过urlopen取到response,并且responsegetcode等于200但若url无效,无论是无法找到服务器还是其他。

Urllib3的主要使用方式是通过连接池进行网络请求,首先需要创建连接池对象其主要API语法格式为requestself, method, url, fields=None, headers=None, **urlopen_kw以下是使用Urllib3发送网络请求的示例代码python import urllib3。

urllib提供urlencode方法用来GET查询字符串的产生,而urllib2没有这是为何urllib常和urllib2一起使用的原因urllib2模块比较优势的地方是urlliburllib2urlopen可以接受Request对象作为参数,从而可以控制。

def get_xsrffirstURL = quot#signinquotrequest = urllib2RequestfirstURL,headers = headersresponse = urllib2urlopenrequestcontent = responsereadpattern = recompiler#39name=quot_xsrfquot value=quot*urlopen与get区别?quot#39,reS_xsrf = refindallpattern,contentretu。

getjpgpy coding=utf8import urllibdef getHtmlurlpage = urlliburlopenurlhtml = pageread return htmlhtml = getHtmlquotprint html Urllib 模块提供了读取web页面数据的接口,我们可以像读取本地文件一样读取。

使用拨号上网的话,一般都有一个本地ip和一个外网ip,使用python可以很容易的得到这两个ip使用gethostbyname和gethostbyname_ex两个函数可以实现代码如下import socketlocalIP = socketgethostbynamesocketgethostname#这个得到本地ipprint local ip%s %localIPipList = socketgethostbyname_exsocke。

def GetWebPage x #我们定义一个获取页面的函数,x 是用于呈递你在页面中搜索的内容的参数 url = #39。

url = 连接allData= content = urlliburlopenurlreadsoup = BeautifulSoupcontenttags1 = soupfindAll#39tr#39, class even righttags2 = soupfindAll#39tr#39, class odd right上面的就是利用写的一些代码,是要取出网页中class 为even right 的所有tr和所有class为odd right。

被403,应该是访问前后的token不对,造成不对的主要原因是第二次访问的cookies跟第一次不一样,脚本里面的第一次访问没有记cookies,导致第二次是全新的访问所以data = urlreaddecode#39utf8#39token = getXSRFdataopener = getOpenerheader改为opener =。

相关推荐